您如何控制在线巨魔?禁止他们?要求实名?

斯坦福大学计算机科学博士后研究员Srijan Kumar博士正在开发一种预测在线冲突的AI。他的研究使用数据科学和机器学习来促进健康的在线互动,并遏制欺骗,不当行为和虚假信息。

他的工作目前部署在印度电子商务平台Flipkart中,该平台使用它来发现伪造的评论者。在南加州大学的健康在线互动之前,我们与库马尔博士进行了交谈。

库马尔博士,你如何利用数据科学和机器学习来抵消在线骚扰?您的系统如何识别巨魔?在我的研究中,我建立了数据科学和机器学习方法来解决在线不当行为,这些不当行为表现为虚假信息和恶意用户。我的方法有一个双重目的: 第一,表征他们的行为,第二,在他们损害其他用户之前检测他们。我已经能够调查各种各样的在线不当行为,包括欺诈性评论、恶作剧、在线拖钓和多个账户滥用等。

你是如何教人工智能发现这些模式的?我开发统计分析、图挖掘、嵌入和基于深度学习的方法来描述正常行为的样子,[并] 使用它来识别异常或恶意行为。通常,我们也可能有恶意行为的已知示例,在这种情况下,我创建了监督学习模型,其中我将这些示例用作训练数据,以在其余示例中识别相似的恶意实体。

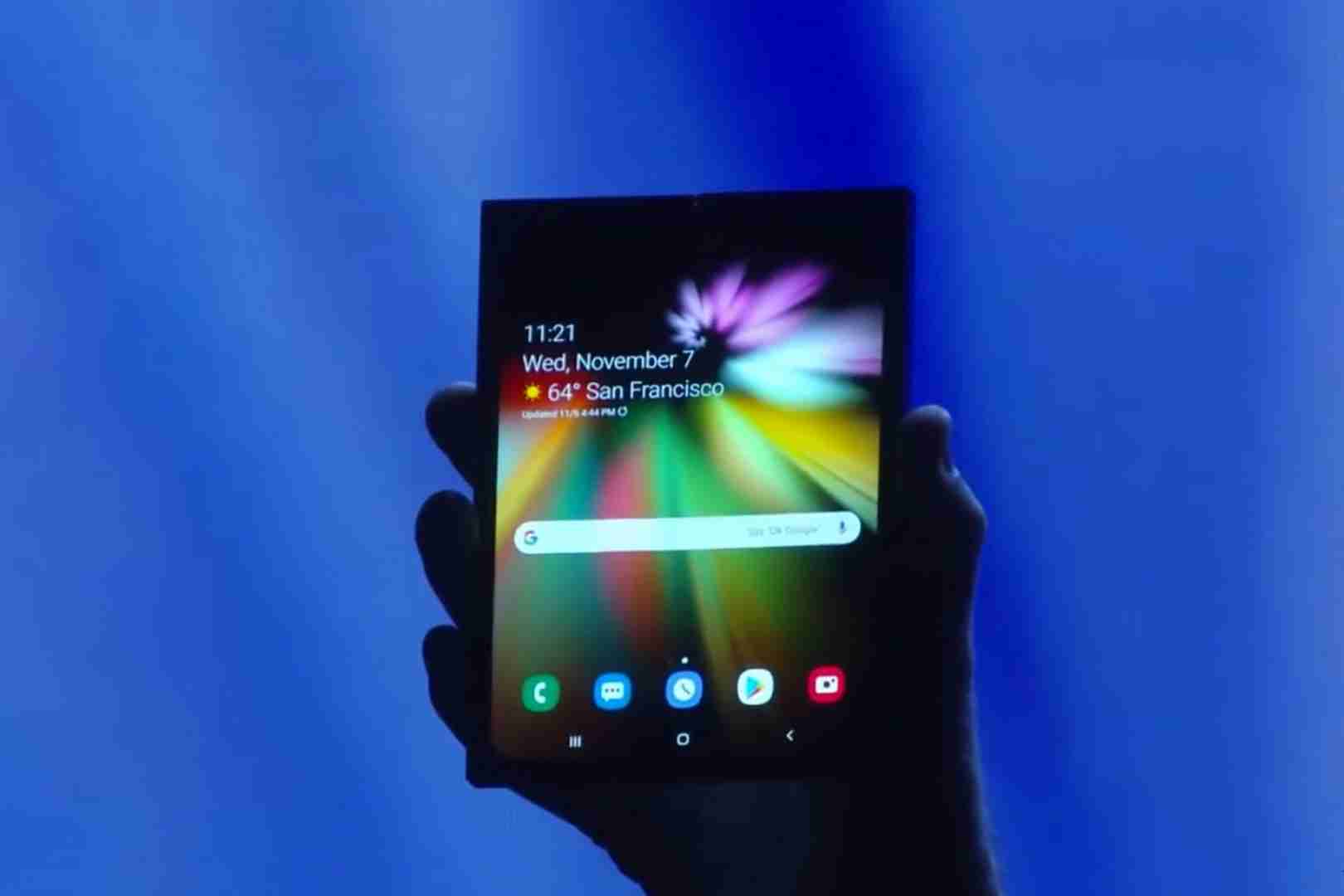

您的研究目前正在Flipkart中使用。他们试图解决什么问题,他们如何衡量结果?我在Flipkart上帮助解决的关键问题是在他们的平台上识别虚假评论和虚假评论者。在所有平台中,这是一个棘手的问题。最近的调查估计,多达15% 的在线评论是伪造的。因此,识别并清除虚假评论至关重要,因为我们作为消费者的决定会受到虚假评论的影响。

这里叫什么方法?我的方法被称为REV2,它使用用户-评论-产品的审查图来识别欺诈者 [谁] 给予低质量产品高评分或高质量产品低评分。REV2 [比较] 我们的建议与以前发现的假审查员案例。

当不良行为即将出现时,人工智能是否有可能密切关注社交网络并发出警报?这是纯粹的基于模式的分析,有感知的数据处理还是完全不同的东西?通过从以前的这样的案例中学习,可以主动预测什么时候可能出错。例如,在我最近的研究中,我表明可以准确预测Reddit在线平台中的一个社区何时会攻击/骚扰/巨魔。这种现象被称为 “旅”,我证明旅减少了未来对被攻击社区的参与。这对用户及其交互是有害的,这需要使用方法来避免它们。因此,我创建了一个基于深度学习的模型,该模型使用文本和社区结构来预测一个社区是否会攻击另一个社区。这样的模型具有实际用途,因为它可以提醒社区主持人注意即将到来的攻击。

您是否看到在 “轻推” 中使用您的作品的逻辑推断,以提示用户在起诉之前清理其行为?就像班级前面的老师在后排的麻烦制造者陷入犯罪策划团伙之前保持警惕吗?绝对! 一项自然而令人兴奋的后续工作是如何劝阻不良行为者进行恶意行为,并鼓励每个人都变得良性。这将帮助我们为每个人创建一个健康、协作和更具包容性的在线生态系统。要实现这一目标,有许多有趣的挑战,需要新的干预方法和更好的预测模型。实现更好的在线对话并推动人们成为他们更好的自我将是我前进的主要方向之一。

您是否有在线骚扰的个人经验,或者这对您来说是一个有趣的AI问题?我遵循这个研究方向的主要原因之一是看到我的一些朋友受到社交媒体巨魔的骚扰。这导致寻找非算法方法来遏制这一问题。作为一项具有挑战性的任务,它激起了我内心科学家的兴趣,我最终学会了创建数据科学和机器学习方法来帮助解决这些问题。

郑重声明:本文版权归原作者所有,转载文章仅为传播更多信息之目的,如作者信息标记有误,请第一时间联系我们修改或删除,多谢。